讓AI「長出手」,自己學會Google、找計算機!Meta新訓練方式Toolformer厲害在哪?

從去年開始,許多人工智慧工具開放公眾使用,從AI圖像生成工具Midjourney、Stable Diffusion揭起大眾的興趣,再到去年年底人工智慧聊天機器人ChatGPT成為公眾話題。儘管讓AI生成圖像和文字相當有趣,但這些工具要進入我們的日常,還有很長的一段路──大多數AI模型都有其局限性,例如沒有最新的資料、會對事實產生「訊息幻覺」、缺乏進行精確計算數學等等。

在ChatGPT還在嘗試克服這些缺點、挑戰Google搜尋引擎地位的同時,Meta冷不防從一旁殺出,用一篇新論文實踐這些問題的解套:讓AI自己使用外部工具。換句話說,如果AI沒有最新資訊,那就讓它自己搜尋最新的資料;如果不會算術,就去找計算機,諸如此類。

生成字句的同時呼叫API,將問題與運算「外包」

這個方法不是Meta獨創,但是被稱為「Toolformer」的這個方法也克服了先前讓AI使用外部工具的障礙;原先的方式仰賴人工註釋,或需要限制在特定的任務內容,導致語言模型與外部工具的結合難以推廣。但Toolformer在產生文字的過程中,遇到特定字詞或需求,就會直接呼叫工具的「API」,叫出搜尋引擎或是計算機。

例如,讓ChatGPT相形見絀的算數:

或是確切日期,呼叫月曆來查詢:

甚至直接搜尋:

Toolformer經過優化,可以自主決定要使用哪些API,以及使用哪些參數來運算或是查詢。而這個的學習過程被稱為「自我監督」:研究人員只需要讓語言模型學習「少量」人工編寫的API呼叫範例,而這些範例已經被手動標註會使用到API的部分。然後再讓語言模型去生成更多包含這些範例的資料庫。

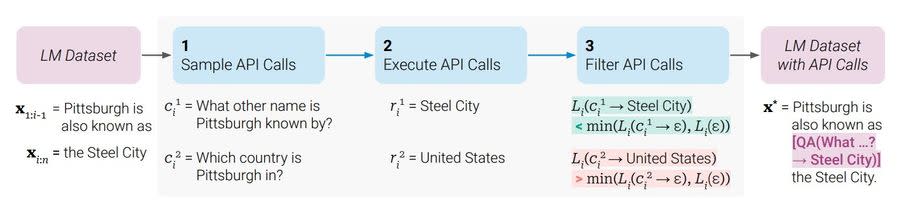

而訓練的過程分成三個步驟:第一是取樣,就是看輸入到語言模型的文字當中,哪些地方可能會需要那哪些工具,就直接把要呼叫API的指令插入句子當中。再來,就是執行這項API指令,並把產生的答案插入對應的部分。

第三步是過濾,如果第二步所生成的文字對整句話的意義不大的話,就會直接剔除,僅保留整句話原本所需要的資訊。

與其他大型語言模型比較起來,Toolformer又有哪些厲害之處?

在Meta的論文當中,比較了Toolformer與多個其他大語言模型,包括GPT-J,OPT(66B)以及GPT-3(175B)在數學、問答以及機器翻譯等方面的能力;研究結果顯示了在學習使用工具後,GPT-J的零樣本學習能力明顯增加,甚至優於GPT-3模型。在數學、QA與LAMA基準測試上的平均表現也有所增強。

研究人員也表示,使用API除了能得到更精準的輸出結果,語言模型自身使用外部工具的能力,也可以解決例如數學運算與事實查核等大型語言模型常有的問題。

不過同時,研究人員也指出,這個系統還是有其局限性。例如,API工具無法連續使用,或是使用一個輸出作為下一句的輸入,因為每個工具的指令是獨立生成的,導致應用範圍有所限制。

延伸閱讀:明明也擁抱AI,祖克柏在AI大戰中版面超少?Meta 科學家喊冤:我們不夠「好命」

語言模型掌握工具,已是未來語言模型發展趨勢

科技巨頭的人工智慧之戰,加入戰局的Meta顯然也不輸微軟與Google;雖然現在聲浪尚無法比上ChatGPT引發的一片譁然,但Meta讓語言模型對工具的使用自主性與熟練度更了上一層樓。

儘管Toolformer所展現出的「自學」能力可能還是個雛形,但顯然語言模型發展的下一步,就是要訓練它們知道在什麼時間、要用什麼工具,且一切的輸入、輸出都可以轉化成自然語言。

這勢必會全然改變人們操作電腦與網頁的方式,而現在也不只Meta走向這個潮流;微軟的Bing搜尋引擎將接入ChatGPT,而Google推出的人工智慧Bard即將嵌入到Google搜尋當中。

資料來源:the decoder、Towards AI、新浪科技

責任編輯:錢玉紘

更多報導

AI大戰中,祖克柏版面超少?Meta AI 科學家:我們也有技術,只是沒那麼「好命」

ChatGPT拔得頭籌的秘密:挖角前Google AI員工!搜尋巨頭為何留不住人?

相關內容

「宜蘭至羅東鐵路高架化計畫」 政院與宜縣府協商配合款調降至57.55億元

宜蘭縣代理縣長林茂盛今(九)日到行政院出席「宜蘭至羅東鐵路高架化計畫」綜合規劃研商會議。會中,中央各部會與縣府就地方財政負擔進行協商,朝向將地方配合款調降至五十七點五五億元的方向取得重大共識。代理縣長林茂盛代表宜蘭縣民感謝行政院陳金德政務委員的協調及支持,並懇請中央今年底前完成綜合規劃計畫的核定,力拚鐵路高架一二四年如期通車。代理縣長林茂盛代表縣民感謝陳政委對宜蘭交通建設的重視,於國發會十二月十日審議前特別召開此次專案協商會議,使地方訴求得以充分討論。林茂盛重申,縣府承諾全力配合後續行政程序,盼中央能於今年十二月底前完成計畫核定,中央地方共同努力加速推動鐵路高架一二四年如期通車,藉以消除平交道交通瓶頸、縫合鐵路兩側土地,帶動地方整體發展。代理縣長林茂盛表示,宜蘭縣財政相較 ...

台灣新生報 ・ 1 天前 ・ 1

藍拋助理費除罪化!他轟藍11人涉案破6千萬

[NOWnews今日新聞]國民黨立委陳玉珍拋出助理費除罪化,就連總召傅崐萁都稱是「進步法案」,引發朝野立委助理炸鍋,更連署向立法院長韓國瑜陳情,對此青年共好協會理事長張育萌今(10)日發文細數藍營過去...

今日新聞NOWNEWS ・ 4 小時前 ・ 發起對話

金價卡位4200大關!美元反彈施壓 全球避險潮再來原因曝

[Newtalk新聞] 黃金市場受惠美元指數開盤走軟,出現技術性反彈並突破 5 日均線(約4,207 美元),但市場在重大數據公布前觀望氣氛濃厚,多頭缺乏進一步推升動能,導致盤勢呈現上有壓、下有撐之格局,金價於 4,205〜4,218 美元之間波動。截至今天(9日)黃金交易價來到4179(盎司/美元)。 台銀表示,歐洲央行執委 Isabel Schnabel 受訪時對歐元區的經濟成長持樂觀態度,同時對市場預期歐洲央行下一步利率調整,將採取升息的看法表達贊同,並認為歐央行可能在 12月18日的會議中調高經濟成長預測,偏鷹言論提振歐元兌美元,然市場預期聯準會對明年貨幣政策路徑保持謹慎,美元指數反彈上行,迫使金價回落至4,200美元下方,並於4,176〜4,196美元區間逐步收斂,最後報價4,188.59美元。 全球再掀避險潮 道富銀行在2026年黃金展望中指出,全球債務於2025年中升至340兆美元,政府占比創下30%新高,龐大債務與通膨壓力推升長期利率,使黃金成為對抗貨幣貶值與利率風險的避險工具。 道富銀行也指出,美股與美債相關性仍處歷史高檔,投資組合分散效果受限,凸顯黃金在資產配置中的

新頭殼 ・ 1 天前 ・ 發起對話

新北市刑大爆洩密案! 2警移送新北地檢複訊

新北市刑大爆出洩密案!偵一隊鄭姓代理副隊長和趙姓偵查員以及金山分局王姓巡佐等3人,今(9)日上午陸續遭檢調搜索約談。檢方疑似接獲檢舉指出,鄭姓員警在2023年擔任小隊長期間,曾接受黑道宴請並洩漏案件偵

台視新聞網 ・ 1 天前 ・ 發起對話

最大近9公分!日本青森7.5強震多處地殼位移

[NOWnews今日新聞]日本青森縣昨(8)晚發生規模7.5強震,最大震度6強,造成至少30人受傷。日本國土地理院初步觀測指出,地震造成地殼出現明顯變動,震央附近的電子基準點在地震後前後,地殼約向東位...

今日新聞NOWNEWS ・ 1 天前 ・ 發起對話

羅省岡州保安堂 新職員宣誓就任

具有120年歷史的羅省岡州保安堂日前舉行2026年職員就職典禮,由2025年起帶領堂務的主席劉國賜及其團隊全數連任。新一...

世界日報World Journal ・ 7 小時前 ・ 發起對話

YouTube 2025 年度榜單來了! Andy老師奪冠、emo神曲擊退《Golden》

YouTube 表示,2025 年即將邁入尾聲,為了慶祝 YouTube 全球 20 週年,今年準備了更特別的方式和大家一起分享這個里程碑:不只要公布台灣的年度熱門排行榜,更推出全新的「YouTube...

華視 ・ 1 天前 ・ 發起對話

台泥三元電池廠大火燒掉162億元,中鼎也要賠46億元?兩大集團將對簿公堂

台泥(1101)旗下三元能源高雄電池廠今年7月發生大火,一場祝融之災整整燒掉162.4億元,如今決定向國內統包工程大廠中鼎(9933)及其子公司益鼎提起民事訴訟求償46.2億元。中鼎對此強調,三元公司的主張「依契約及依法均無理由」,目前已經委任律師團隊準備應訴,藉此捍衛公司及投資人權益。台泥第三季營運由盈轉虧,主因三元能源高雄電池廠火災事故造成資產及存貨損毀......

風傳媒 ・ 21 小時前 ・ 2

竹科夢破碎!頂大碩士連收6封「台積電屎缺」邀約 1原因超後悔:認命了

被譽為「護國神山」的台積電福利待遇優渥,是許多人夢想進入的大公司,但不少人會事先打聽,希望避開勞累度較高、被稱為「屎缺」的職位。一名成功大學電機碩士近日分享求職經歷,他原本想前往竹科工作,沒想到連續收到6封台積電「設備工程師」面試邀約,而且工作地點越來越偏,讓他直呼後悔,覺得自己應該早點接受面試。貼文曝光後,立刻掀起熱議。

三立新聞網 setn.com ・ 7 小時前 ・ 4

預拌混凝土廠「桶槽崩塌」 工人奔逃 驚悚瞬間曝光

桃園觀音區一預拌混凝土廠9日發生嚴重倒塌事故!廠內2座飛灰儲槽在進行更換作業時突然崩塌,現場結構瞬間垮塌並揚起大量塵土,工人嚇得倉皇逃出。鄰居指出支架鏽蝕可能是崩塌原因,而廠商解釋是因設備老舊所致。勞檢處已派員了解災害經過並進行輔導,督促廠商以安全方式進行拆除作業。所幸當時未造成任何人員傷亡,但也讓在廠中作業的工人受到了極大驚嚇!

TVBS新聞網 ・ 3 小時前 ・ 發起對話

IT Matters Awards頒獎(2) (圖)

2025第3屆IT Matters Awards頒獎典禮9日在台北舉行,行政院長卓榮泰(圖)擔任頒獎人,致詞發表談話。

中央社 ・ 1 天前 ・ 發起對話

【生活特輯】新北交通安全革新 科技執法、友善路口讓每一步都安心

「安全、順暢、友善」是新北市全面推動道路交通安全革新的核心。市府統合交通、工務、執法、教育等單位力量,致力降低事故風險,打造宜居交通環境。

鏡新聞 ・ 1 天前 ・ 發起對話

痛經怎舒緩?腹痛、疲倦、水腫⋯中醫調理「4類體質」針灸、艾灸有用

一名30多歲的女工程師因長期承受工作壓力,久坐且不運動,每次月經前一週出現情緒起伏、焦慮、乳房脹痛等症狀,經期時更常痛到需服用止痛藥,經過數週的中醫調理後,不適症狀才逐漸改善。醫師表示,經前症候群是女性最常見、卻也最容易被忽視的健康問題,月經不適明顯增加,可能與4大因素有關。

優活健康網 ・ 6 小時前 ・ 發起對話

共機雷達照射日本F-15「稱如打開手電筒」 軍事專家打臉:只差扣板機

日本與中國海空較勁意味濃厚,日方近日指控,日方F-15兩度遭到中共解放軍遼寧號的艦載機以雷達照射,日方強烈抗議,更加溫中日之間的緊張關係。沒想到,中共官媒央視訪問所謂的軍事專家,竟聲稱雷達照射就像打開手電筒,是正常操作;但是軍事專家表示,戰鬥機上的雷達用途,絕非一般的搜索,是進入瞄準模式,「鎖定之後,如同拿槍瞄準,只差扣板機」。

太報 ・ 1 天前 ・ 5

10x10 Awards/《Hodinkee Japan》編輯長 關口優的年度十大錶款是哪些牌子?

今年我們邀請到《Hodinkee Japan》編輯長 關口優(Yu Sekiguchi),為10x10 Awards選出他的年度十大錶款。在2019年加入Hearst Digital Japan,隨後成為《Hodinkee Japan》編輯長的關口優,對手錶有著濃厚的興趣與熱情,關於業界趨勢他也有著敏銳的觀察與獨到的見解。來看看關口優對於今年的鐘錶界有什麼看法、對於明年又有哪些預測呢?

鏡週刊Mirror Media ・ 1 天前 ・ 發起對話

台南研考會前主委蒙志成涉貪6萬2240元 南檢偵結起訴

台南市政府研究發展考核委員會前主委蒙志成,在職期間涉嫌不當使用特支費6萬2240元,作為私人聚餐等非公務用途,其妻子也被列為共犯。台南地檢署日前偵查終結,起訴蒙志成夫妻兩人,請求量處適當之刑。

Yahoo奇摩(即時新聞) ・ 9 小時前 ・ 2