【2023人工智慧年會】哈佛教授:AI發展正處於「奧本海默時刻」

哈佛法學院教授勞倫斯·萊斯格(Lawrence Lessig)以「人工智慧與法律(AI and the Law)」為題演講,他以「AI 能對法律做什麼?」及「法律能對 AI 做什麼?」兩個面向探討 AI 與法律之間的關係。

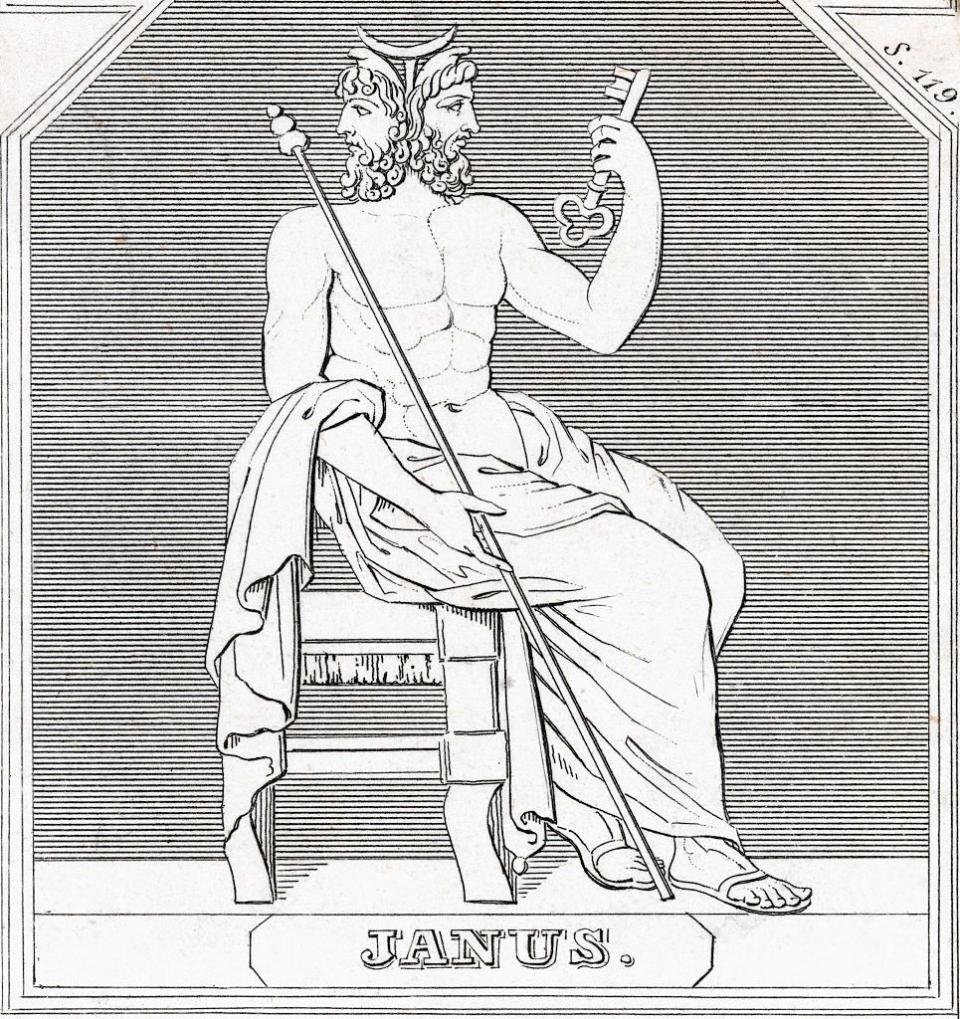

他指出,這兩個問題將產生兩個截然不同但又相互關聯的答案—一個充滿希望、甚至令人振奮,另一個則充滿恐懼。而現實情況是,AI 和所有技術一樣,如同雅努斯的臉(Janus-face)具有雙面性,它將呈現哪一張面孔則取決於人類?

Janus-faced:這個詞彙來自羅馬神話中的雙面神 Janus,用來描述某人或某物具有相互矛盾或對立的雙重性質或特點。

AI 能對法律做什麼?

為了說明 AI 在法律實務中扮演的角色,萊斯格分享他在最高法院為總統選舉人權力的案件辯護的經歷,令他驚訝的是,法官們似乎不熟悉此案關鍵的先例-雷訴布萊爾案(Ray v. Blair),「該贏的時候卻輸了」。

這凸顯出法律實務上的一個系統性問題,即很多法官在沒有徹底閱讀和理解相關資料的情況下做出判決。目前的法律體系常常難以近人、昂貴且不可靠,特別是對那些負擔不起律師費的人。

「法治猶如一條黃金磚鋪成的道路,大多數人生活在這樣的系統中,必須支付大量的黃金,才可能抵達正義的終點。」

然而,AI 有潛力顛覆法律系統的潛力,其低成本和高效率能使正義變得更加觸手可及。它可以閱讀和分析大量的法律資料、撰寫法律文件,甚至協助判決。

「但這樣的好事不會自己發生。」萊斯格說,他提出五大原則,強調必須確保 AI 在遵循這些框架下運作:

公眾可及性:法律領域的 AI 技術必須透過各種方式向大眾開放,無論是許可、補貼、授權,必須確保它是一項公共資源,為每個人提供服務。

可解釋性和可經測試:AI必須透明並經過嚴格測試,以消除偏見、錯誤和不公平。它應該可由獨立專家驗證出可靠結果,不受提供者的任何限制。

無過失責任:系統即使不存在過失,也需要承擔損害賠償責任。所有錯誤的全部成本必須由 AI 系統承擔,不僅是文件費用,還包括法律費用和受影響方的時間成本。

可苛責性:人們可以說「AI 已經失控」來撇清責任,這件事應該被反轉。當意外發生,最終必須有一個人或一群人負責。

拒絕版權苛政:AI 模型使用受版權保護資料的爭議與日俱增,萊斯格認為,「侵權」是錯誤的行為,大公司獨占大部分價值,而創作者卻收到很少回報。但他也呼籲,在保護創作者的同時,不應讓版權成為創意和知識共享的障礙。

法律能對 AI 做什麼?

過去十年,Google 主張演算法應受到《美國憲法第一修正案》對於「言論自由」的保護。當演算法選擇性地推播內容時,就像《紐約時報》的編輯決定版面一樣,任何規範「編輯選擇」顯然都是違憲的。因此,從這個角度來看,任何監管演算法的措施也都是違憲的。

然而,這一觀點正受到強烈的反對。反對派認為,是時候讓社會認識到 AI 已經超越人類所控制的「複製品(replicates)」,其言論不應受到憲法保護。這一觀點得到了先前裁決的支持,即政府可以將外國公民排除在與「民主政府過程密切相關」的活動。那麼如果這些真正的人類都不被視為民主的一部分,AI 也不應如此,因此有必要將 AI 排除在憲法保護之外。

這一觀點並非否認 AI 的潛在權利,萊斯格指出,「如果有一天 AI 擁有人性,不應該像機器一樣被對待,我絕對支持投票讓它擁有權利,但它的權利應該是爭取來的,應該是我們的選擇,而不是 1789 年的憲法制定者。」

可悲點理論(Pathetic dot theory)

即使演算法排除在憲法保護的範圍之外,問題是該如何監管? 當前的氛圍充滿對於通用人工智慧(AGI, Artificial General Intelligence)技術的未知能力和後果的焦慮,這些技術的開發成本巨大,但由於其數位化特性,可以輕易地擴散。

甚至開發人員也在敦促進行規範,經調查顯示,開發人員認為 AGI 有 10% 的可能性成為生存威脅。在考慮潛在的規範策略時,萊斯格提出「可悲點理論」,利用法律、社會規範、市場和代碼去規範 AGI ,每種方法都有自己的一套挑戰和影響。

法律規範:雖然法律看似一個有力的工具,但開源代碼的出現,使得 AI 技術難以施加控制,尤其是當開源碼擴展到各地。

社會規範:依賴社會規範可能太過天真,因為它可以被市場力量所推翻,正如許多Facebook 工程師努力做出正確的事,卻被「商業模式」的指令推翻,「市場總是會吃掉文化(Market eats culture every time. )」。

市場規範:引入市場控制,如二次循環稅似乎是一種明智的方式,使用愈多循環,須繳愈多的稅,這將減緩激勵措施,但這需要透過國會立法。

代碼規範:規範代碼本身的可能性,以激勵開發人員創建安全的技術。這裡的重點是,只要規範少數幾家控制 AI 晶片生產的公司(一家IC設計公司、三家晶圓代工公司),就可以避免可能的災難性後果。

AI 技術處於「奧本海默時刻」

萊斯格將此與核彈之父奧本海默(Oppenheimer)所進行的曼哈頓計劃相比,表明 AI 正處於「奧本海默時刻」,適當干預可以防止具有潛在危險的 AI 技術不受控制的擴散。

許多人認為,應該在晶片上安裝一個限流器,讓代碼直接控制晶片。但將監管系統直接建入晶片內,這引起了一系列問題:該管控這樣的治理系統?誰將負責監管這個系統?誰來決定何時開啟或關閉這些限流器?

開源軟體不需要高階晶片就可以進行開發,接下來難道也需要禁止開源軟體?或者在所有晶片上安裝監管系統,藉此控制每一個晶片(包括每部手機)以決定何時你的運算速度過快需要被限制。

萊斯格認為,答案不是控制晶片,也不是禁止開源軟體,而是要加強網路安全,預估網路安全的支出將增加 30 倍。

另一個方案,萊斯格提到,19 世紀製藥公司生產藥品後可直接在市場上銷售,當它們被證明是毒藥時,民眾可以去找製藥公司要求賠償。但許多人在訴訟前就死了。到了 20 世紀,製藥公司必須證明藥物安全有效,才能進入市場。

萊斯格說, AI 技術也應如處方藥物般看待,開發者必須證明其安全性,或至少建立煞車機制。這可能是一種侵入性較小的監管結果。

我們如同坐在一輛狂飆的轎車裡,很多人大聲疾呼,踩剎車是對基本權利的侵犯,大公司們有權盡可能瘋狂地競賽。但萊斯格建議,應把 AI 的發展速度降到人類可控的速度。

結論

這兩個結論基本上是不一致的,一個是應該用 AI 協助判決,另一個是應減緩 AI 發展。對於這前後矛盾的指控,萊斯格給出二個理由。

第一,兩者在規模上有顯著地差異。AI 能更有效地處理某些法律文件,而且不會接管世界。但 AGI 不是那麼容易控制,因此有所區別。

第二,法律誤判是如此可怕,任何有效的補救措施,都應被視為是安全的。我們應該承擔風險,無論風險是什麼。

隨著時間的推移,這些問題將變得複雜。人類必須以批判性的思維來應對這些挑戰,並且考慮到所有的可能後果。

如果我們選擇了一條不當的道路,我們可能會失去一些珍貴的東西。但是,如果我們選擇了正確的道路,那麼將有可能創建一個更加安全、繁榮的未來。

核稿編輯:湯皓茹

《商益》主張「商業是最大的公益」,報導專注於讓讀者理解資本力量、商業本質以及財經語言。歡迎加入 Discord 社群,並免費註冊訂閱商益電子報。

延伸閱讀:

【2023人工智慧年會】簡立峰揭AI產業7趨勢、4挑戰:「至今還沒人賺到錢」

【2023人工智慧年會】Google Bard推手紀懷新:對話AI把算力推到極限

【2023人工智慧年會】抱持國父革命精神與AI共舞!廣達林百里喊:「免驚啦!」

【2023人工智慧年會】入列《時代》百大人物!唐鳳親揭 AI 擴展「協商式民主」

Yahoo奇摩財經

Yahoo奇摩財經