NVIDIA GPU斷炊!日經:日本AI企業的LLM開發進度岌岌可危?

隨著生成 AI 技術的快速發展,許多公司發現想取得必要的 GPU 資源以開發大型語言模型(LLM,Large language model),特別是使用公共雲的用戶,試圖在公共雲上找到適當的 GPU 伺服器(伺服器上的執行環境),已經難如登天。

日本經濟新聞今(12 日)報導,日本專注於開發 LLM 的企業呼籲,若現狀持續下去,想要實現日本獨立開發的 LLM 時程,將比預期的更慢。

在日本 AI 新創「Stockmark」領導研發部門的近江崇宏執行董事表示,「我們想要研發 LLM,然而現在主流的公共雲服務中,幾乎搶不到搭載 AI 用 GPU『NVIDIA A100』的 GPU 伺服器。我們上週(8 月最後一週)連一台都沒搶到」。

該公司自 2023 年 4 月起與產業技術總合研究所(「産総研」,日本政府成立的公立研發機關)合作進行日語 LLM 的共同研究,也使用産総研的 AI 超級電腦「ABCI(AI Bridging Cloud Infrastructure、AI 橋接雲)」進行 LLM 訓練。

Stockmark 8 月順利公開、並開源在 ABCI 上訓練的 14 億參數日語 LLM。但是到 9 月,Stockmark 已經很難在 ABCI 搶到 A100 GPU 伺服器。

根據産総研指出,從今年 6~7 月間需求就大幅暴增了。

為了確保 AI 基礎設施,LLM 開發公司正採取各種方法。

日本 AWS(Amazon Web Services)9 月宣布了「AWS LLM 開發支援計畫」支援對象企業。該計畫提供用於 AI 基礎設施的 AWS Credit(使用權)以及技術支援。

被選中的公司包括 CyberAgent、Stockmark、Preferred Networks(PFN)、Recruit、Ricoh、rinna(りんな)。

rinna

最有趣的是,rinna 是從日本微軟(Japan Microsoft) 獨立出來的,而該公司也申請了 AWS 的支援計畫。rinna 的 Research and Data Manager 沢田慶表示,

AI 產品的進化速度很快,所以絕對是開發速度先決。只要運算資源便宜、而且馬上能用,在哪裡做我們都不在意。

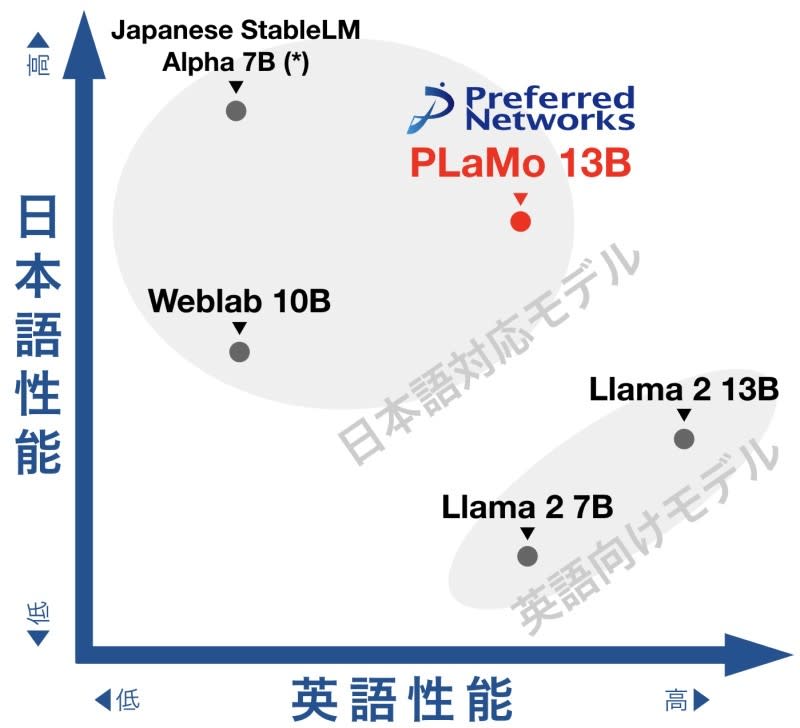

PFN

PFN,則是已經自主開發用於深度學習的「MN-Core」系列晶片、還打造出搭載 MN-Core 系列的 AI 用超級電腦。即使如此他們也在外部尋找大量的 AI 基礎設施。PFN 不僅參與 AWS 的計畫,還持續大量使用産総研的 ABCI。

産総研從今年 8 月展開「大型語言模型建構支援計畫」,ABCI 配備了 8 個 A100 的 GPU 伺服器,共有 120 個節點。單一企業一次可以分配到一半的量、使用期間 60 天。費用由使用者支付,PFN 爭取到成為首批批使用者。

PFN 的媒體公關窗口回應日経採訪表示,

LLM 要配合資料量與運算資源,才能發揮一定程度的性能。在目前的技術下,如果搶佔不到一定程度的運算資源的話,就無法開發 LLM。

靠雲服務商太麻煩!我可以自己來嗎?

最麻煩的是,即使 LLM 開發商想要不靠雲服務商、自己花錢搞定 GPU 伺服器也幾乎不可能。搭載 AI 用 GPU 的伺服器非常耗電,可以跑得動的資料中心很有限。房地產業者「MC Digital・realty」表示:「需要跟得上性能的超高供電、以及冷卻能力。」

日本政府經產省的支援:for 日本國內的 GPU 雲

然而,2024 年日本或許有機會迎來緩解 GPU 伺服器短缺的轉機。因為一些取得經產省補助的企業,正在打造搭載 A100 後繼款 GPU「NVIDIA H100」的 GPU 伺服器雲服務。

日本經濟產業省基於經濟安全保障推進法,推動補助計畫「cloud program」。接受補助的日本企業,可以從 NEDO(新能源・產業技術總合開發機構)的基金中獲得補助款。Sakura Internet,以及 SoftBank 分別於今年 6(68 億日圓)、7 月(53 億日圓)通過該計畫,取得資格。

以此,Sakura Internet 計畫到明年 4 月為止,陸續砸下超過百億日圓、在北海道石狩市的資料中心中建構 GPU 雲。預計 2024 年 1 月開始,就可以逐步提供搭載 H100 的 GPU 伺服器雲服務。這個 GPU 雲將搭載 2000 個以上的 H100。

SoftBank 則在今年 5 月宣布打造「分散型 AI 資料中心」。規劃的一部分、到 2024 年 3 月為止,將投入總額 200 億日圓建造 GPU 雲服務。SoftBank 的服務中心將導入 AI 超級電腦「NVIDIA DGX SuperPOD」。

NVIDIA 在今年 8 月的財報表示,接下來幾季還會提升 AI 用 GPU 的產能。儘管如此,在生成 AI 的熱潮還不見降溫的當前,很可能即使擴大了 GPU 供應、也跟不上需求。LLM 開發商或許還要提心吊膽一段時間。

《商益》主張「商業是最大的公益」,報導專注於讓讀者理解資本力量、商業本質以及財經語言。歡迎加入 Discord 社群,並免費註冊訂閱商益電子報。

延伸閱讀:

Nvidia H100 為何短缺?看專家詳解AI市場GPU 供需現況!

AI 伺服器哪檔最純?哪檔題材最多?群益投顧最新報告搶先看

輝達股價再起!華爾街:次世代「Blackwell」GPU 受矚目

中國LLM 洗牌在即,誰將在「百模之戰」中存活?

Yahoo奇摩財經

Yahoo奇摩財經