【圖解】輝達強到「全額付清」才接單!但為何卻獨怕Google?還有哪些「最頂」技術?

生成式AI的橫空出世,點燃矽谷灣區科技巨頭在新賽道上的競爭,瘋搶AI商機。軍火庫則是遠在太平洋另一頭的台灣,小島上掌握了全球近6成的先進製程產能,以及8成的伺服器出貨。美商想做生意,必須與台廠攜手才能前行。

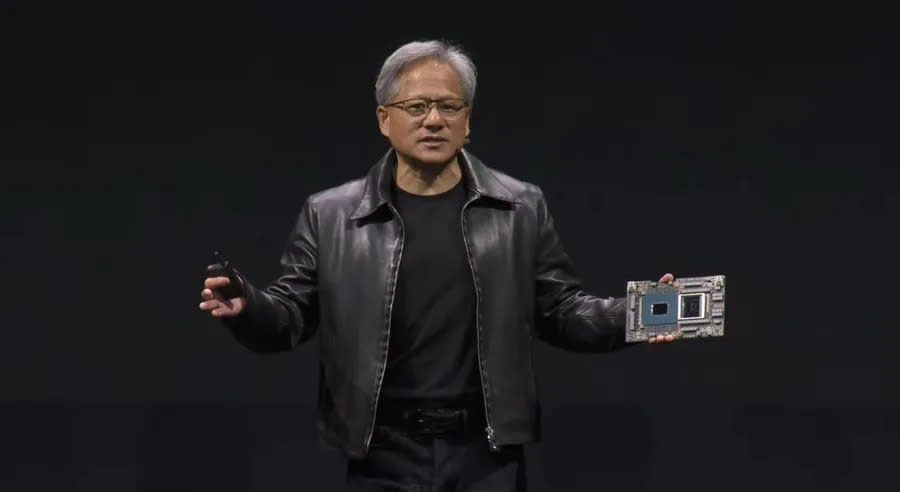

輝達執行長黃仁勳近期再次訪台,不僅與廣達高層會面,更多次在各大夜市被民眾直擊。

「現在搭載輝達(NVIDIA)GPU(繪圖處理器)的伺服器真的非常缺,我有客戶4月下單,9月才會拿到貨,原本大約2周就拿得到。」一名美超微(Supermicro)員工無奈表示。記者再詢問其他廠商,最久等候期竟長達40周。

AI伺服器需求暴漲,散熱模組供應商雙鴻董事長林育申更用「中獎了」來形容近乎瘋狂的需求。ChatGPT的橫空出世掀起企業的AI焦慮,外資法人指出,輝達早在今年的3、4月,就累積一批GPU訂單。

DIGITIMES Research近期一份報告預估,2023年高階AI伺服器出貨量將成長1.5倍,其中輝達光是HGX伺服器占比就超過9成。輝達執行長黃仁勳更在今年第2季的法說會上,給出第3季營收將飆升至160億美元的預估,遠高於華爾街預期的125億美元。

強到「全額付清」才接單!孵30年GPU大豐收

讓市場沸騰的商機,來自AI大型語言模型(LLM)訓練上的需求。GPU和CPU(中央處理器)最大的不同在於處理資料的方式。GPU內的資料可同時進行運算,CPU則須按照順序處理,兩者差別在於功能的不同,所產生設計結果。

由於餵愈多資料至語言模型,最終結果愈精準,因此能同時處理龐大資料,又可以加速運算的GPU則成為AI爭霸戰下的重要物資。輝達超大規模和高效能運算副總裁巴克(Ian Buck)表示,加速運算和GPU一直是輝達的核心,AI運算則是爆發的應用場景。

不過即使需求火熱,輝達仍相當謹慎地挑選客戶。IDC研究副總裁羅吾(Shane Rau)指出,不是有錢就能買輝達產品,「輝達希望他們的產品能成為業界標準,無論是在雲端還是企業端。」因此偏好能長期使用輝達科技且忠誠的客人。

甚至於有些時候,輝達會先要求客戶付清款項才開始準備伺服器製造。一名雲達科技的主管告訴《數位時代》,「這很瘋狂,如果你只下訂單還排不上隊。」羅吾分析,這通常出現在和輝達不熟的客戶身上,「向台積電下單是巨大的承諾,輝達透過先付款的方式來驗證伺服器需求為真。」

需求是真的。巴克表示,已經看到現在資料中心的投資都在想辦法配合加速運算需求,例如散熱設備、電力配置和空間規畫等。耕耘GPU第30載終於迎來巔峰,輝達接下來將如何鞏固龍頭地位?巴克給出答案:豐收期還沒結束,會持續優化資料中心產品。

首先,輝達將持續提升功耗和效能。「人們總看見我們的伺服器很耗電,但如果觀察性能和能耗之間的比例,每一代模型所需要的訓練功耗都大幅降低。」伊恩說。以H100為例,雖然功耗高達700瓦,但同樣是訓練ChatGPT3的1,750個參數,速度為A100的約6倍。

伊恩指出,目前資料中心CPU的Grace CPU已採用具備低功耗特色的Arm架構,超級晶片Grace Hopper更直接將CPU和GPU利用台積電先進封裝CoWoS包在一塊,讓兩者共用供電來源,「如此一來,就能夠根據需求分配CPU和GPU之間的電源,提高能源效率。」

低功耗×超強算力!NVLink稱王「看嘸車尾燈」

其次,則是優化互聯(interconnect)技術。可以想像GPU是辦公室內員工,即使個人處理工作的速度再快,員工間的交接卻耗費好幾小時,整體而言進度仍緩慢,資料的移動就好比交接時的速度。巴克認為,當今AI已非單一顆GPU可處理,須依靠多顆GPU連結,當中資料的移動將是關鍵。

過去,不同的GPU傳輸資料,得靠主機板上的PCIe(高速周邊元件交互連接裝置)先將資料傳回CPU,接著再派發訊息到另一個GPU上。由於PCIe頻寬窄,能運送的資料量有所限制,輝達開發出的「NVLink」頻寬不僅增加5至12倍,最重要的是允許不同GPU間的直接連接,讓資料傳輸更直接並加快運算。

曾任職於創意電子和聯電的IP供應商Expedera銷售副總裁顧威指出:「AI需要大量資料轉換,輝達是現在唯一能把這件事做好的公司。」

輝達最新超級晶片GH200,即採用NVLink技術連接CPU和GPU。DGX系統副總裁暨總經理波以耳(Charlie Boyle)指出,未來輝達也會把NVLink技術應用於伺服器間的連結上。

伺服器喊到35萬太貴,推平替版DGX Cloud攬客

不過輝達伺服器要價高昂,漲價後1台約新台幣30至35萬元,除雲端巨頭外,企業不見得願意花錢購買。為了更全面開發AI客戶,輝達把觸角伸到雲端,推出「DGX Cloud」,於算力供應上布下天羅地網。

DGX是輝達伺服器品牌名稱, DGX Cloud則是由輝達攜手Google Cloud與甲骨文(Oracle)等雲端供應商,在這些雲端大廠上提供AI運算服務平台。這意味企業無需購買伺服器等硬體設備,而是能藉由訂閱的方式,在雲端上享有DGX 的算力。

然而,市場諸多評論認為,輝達此舉無異於賺兩手錢,扼殺與雲端客戶關係。對此波以耳反駁:「我們和雲端廠結盟,是創造雙贏。」波以耳解釋,這項服務目的在於讓想擁有AI模型、但不想購買或無力負擔伺服器的企業使用AI,「DGX Cloud每新增一個客戶,雲端廠也也同樣獲得。」

另外,由於客戶數據可能存放在不同雲端中,輝達因此與雲端廠結盟,讓客戶能更簡單地將數據連結到DGX Cloud,「這也是為何我們會與資料中心合作。」這意味著輝達除了吃下已知的AI市場份額外,也想運用雲端延伸觸角,找出潛在商機,提前觸及未來客群。波以耳指出,輝達看好這塊需求攀升,但強調輝達不會蓋自己的資料中心,「我們會專注擅長的事,並和擅長雲端的夥伴合作。」

目前看來輝達的統治地位穩固。一名美系半導體高層表示,未來想加入AI的企業都很難跳過輝達,再來的對手已經不是半導體企業,而是雲端大廠。這名高層評論,如今雲端大廠都有設計晶片的能力,高估值的AI晶片新創如Cerebras和Groq等很難賣產品,客戶大多是美國國防部。

輝達5年內「無敵手」!只怕Google突襲超車

不過另一方面,該高層也指出:「輝達會怕Google,是因為他們能做出自己的ASIC(AI處理器),Google執行長皮蔡(Sundar Pichai)說至少會跟輝達再買十年晶片,就是說給輝達聽的。」

即使如此,法人認為在未來的3到5年,輝達仍會是AI市場的王者,「像ChatGPT4已有1,750億個參數,最終推論結果卻被認為還不足以商轉,普遍認為要到ChatGPT5才可以,可見模型訓練的基礎建設還需要更多算力,缺口還會存在一段時間。」

輝達

成立: 1993年

執行長: 黃仁勳

AI關鍵技術: GPU運算、CUDA軟體服務

責任編輯:蘇祐萱、謝宗穎

更多報導

【圖解】秒懂ASIC、FPGA!AI對台「10年大進補」,GPU、CPU外還有哪些商機可吃?

【圖解】誰是輝達、超微最強後盾?高階晶片+伺服器紅利怎吃?矽谷、台灣領跑AI商機

Yahoo奇摩財經

Yahoo奇摩財經